파이썬으로 하는 선형대수학 (4. 공분산과 상관계수)

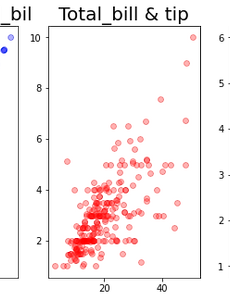

4.1 평균, 분산, 표준편차 (numpy와 pandas의 ddof 디폴트값 차이) def myfunc(data) : mean = np.sum(data)/len(data) var = np.sum([np.power(i - mean,2) for i in data])/len(data) std = var**0.5 return mean, var, std data0 = np.array([243, 278, 184, 249, 207]) data_panda = pd.DataFrame(data0) x,y,z = myfunc(data0) print('평균 : ',x, '\nnumpy : ',data0.mean(), '\npandas : ',data_panda.mean(), '\n\n분산 : ',y, '\nnumpy : ',..

2021. 1. 18.

파이썬으로 하는 선형대수학 (4. 공분산과 상관계수)

4.1 평균, 분산, 표준편차 (numpy와 pandas의 ddof 디폴트값 차이) def myfunc(data) : mean = np.sum(data)/len(data) var = np.sum([np.power(i - mean,2) for i in data])/len(data) std = var**0.5 return mean, var, std data0 = np.array([243, 278, 184, 249, 207]) data_panda = pd.DataFrame(data0) x,y,z = myfunc(data0) print('평균 : ',x, '\nnumpy : ',data0.mean(), '\npandas : ',data_panda.mean(), '\n\n분산 : ',y, '\nnumpy : ',..

2021. 1. 18.

파이썬으로 하는 선형대수학 (3. Span, Rank, Basis, Projection)

3.1 2차원 벡터 a = [1,3] b = [2,6] plt.figure(figsize=(2.5,5)) plt.xlim(0, 3.5) plt.ylim(0, 7) plt.xticks(ticks=np.arange(0, 4, step=1)) plt.yticks(ticks=np.arange(0, 7, step=1)) plt.arrow(0, 0, a[0], a[1], width = 0.05,head_width = .2, head_length = .1, color = 'red', alpha = 0.3) plt.arrow(0, 0, b[0], b[1], head_width = .1, head_length = .1, color = 'blue', alpha = 0.3) plt.axhline(0, color='gray'..

2021. 1. 18.

파이썬으로 하는 선형대수학 (3. Span, Rank, Basis, Projection)

3.1 2차원 벡터 a = [1,3] b = [2,6] plt.figure(figsize=(2.5,5)) plt.xlim(0, 3.5) plt.ylim(0, 7) plt.xticks(ticks=np.arange(0, 4, step=1)) plt.yticks(ticks=np.arange(0, 7, step=1)) plt.arrow(0, 0, a[0], a[1], width = 0.05,head_width = .2, head_length = .1, color = 'red', alpha = 0.3) plt.arrow(0, 0, b[0], b[1], head_width = .1, head_length = .1, color = 'blue', alpha = 0.3) plt.axhline(0, color='gray'..

2021. 1. 18.

파이썬으로 하는 선형대수학 (1. 스칼라와 벡터 & 2. 매트릭스)

1. 스칼라와벡터 1.1 벡터그리기 import math import matplotlib.pyplot as plt import numpy as np a = [6,13] b = [17,8] plt.figure(figsize=(10,10)) plt.xlim(0, 20) plt.ylim(0, 20) plt.xticks(ticks=np.arange(0, 20, step=1)) plt.yticks(ticks=np.arange(0, 20, step=1)) plt.arrow(0, 0, a[0], a[1], head_width = .5, head_length = .5, color = 'red') plt.arrow(0, 0, b[0], b[1], head_width = .5, head_length = .5, color ..

2021. 1. 18.

파이썬으로 하는 선형대수학 (1. 스칼라와 벡터 & 2. 매트릭스)

1. 스칼라와벡터 1.1 벡터그리기 import math import matplotlib.pyplot as plt import numpy as np a = [6,13] b = [17,8] plt.figure(figsize=(10,10)) plt.xlim(0, 20) plt.ylim(0, 20) plt.xticks(ticks=np.arange(0, 20, step=1)) plt.yticks(ticks=np.arange(0, 20, step=1)) plt.arrow(0, 0, a[0], a[1], head_width = .5, head_length = .5, color = 'red') plt.arrow(0, 0, b[0], b[1], head_width = .5, head_length = .5, color ..

2021. 1. 18.